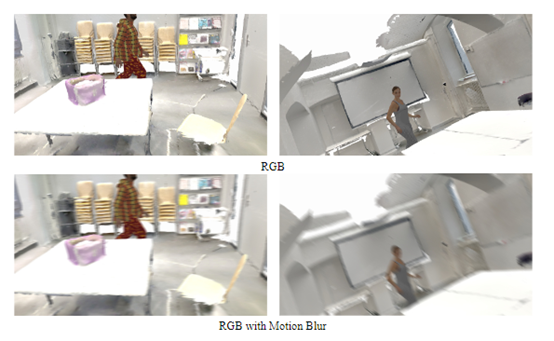

一方面,人工標注真實第一視角數(shù)據(jù)集,來培訓深度學習模型的成本和難度都很高。另一方面,以往用于第三人稱視角的虛擬渲染數(shù)據(jù),無法很好地模擬第一視角下的真實人體運動與環(huán)境交互過程。

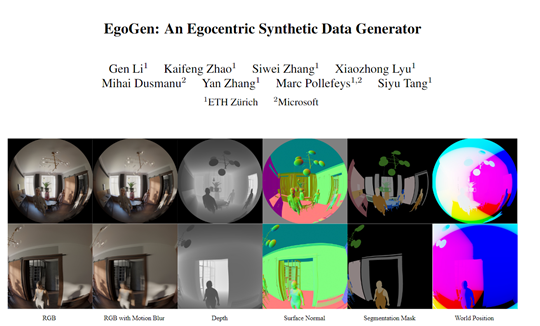

為了解決這些難題,微軟和蘇黎世聯(lián)邦理工學院的研究人員推出了EgoGen,這是一個用于生成第一視角訓練數(shù)據(jù)的模型。

EgoGen不僅具有高效的數(shù)據(jù)生成流程,還能夠適用于多個自我中心感知任務(wù),例如,生成的數(shù)據(jù)可以用于恢復自我中心視角下的人體網(wǎng)格。

論文地址:https://arxiv.org/abs/2401.08739

即將開源地址:https://github.com/ligengen/EgoGen

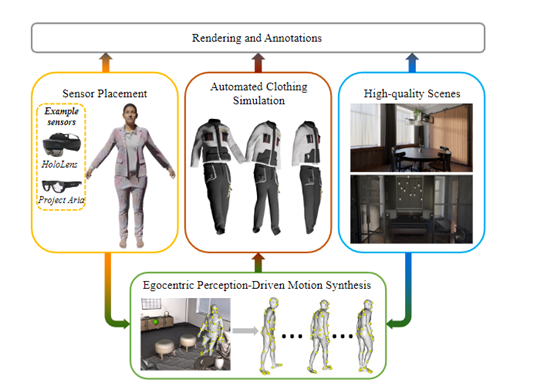

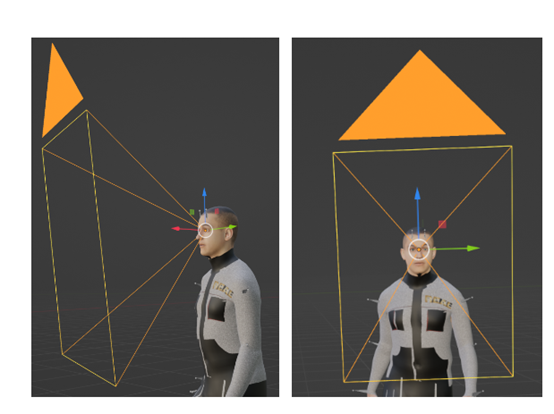

EgoGen使用了一種創(chuàng)新的人體運動合成模型來合成高數(shù)據(jù)。該模型通過直接利用虛擬人的自我中心視覺輸入,來感知周圍3D環(huán)境。

與先前的方法相比,EgoGen的模型消除了對預(yù)定義全局路徑的需求,并且可以直接應(yīng)用于動態(tài)環(huán)境。

生成模型訓練

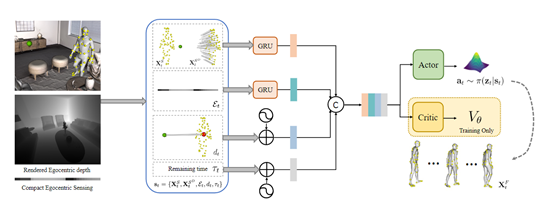

EgoGen模型的第一階段,研究人員使用了一種生成模型來訓練虛擬人物的行為,將身體運動和感知過程無縫地結(jié)合起來。

身體運動與感知的關(guān)鍵點是使虛擬人能夠通過自我感知的視覺輸入看到他們的環(huán)境,并通過學習控制一組避免碰撞的運動基元的策略來做出相應(yīng)的反應(yīng),這些基元可以組合以合成長期的多樣化人類動作。

通常我們生成的運動基元模型具有無界和高維的潛在動作空間,直接通過渲染的自我感知圖像進行策略訓練是很不穩(wěn)定的。

所以,EgoGen使用了一種高效的自我感知視覺代理的雙階段強化學習方案,無縫地將自我感知視覺線索和身體運動相結(jié)合,同時使用了“注意”獎勵來激勵自我感知行為。

強化學習優(yōu)化

研究人員使用了強化學習優(yōu)化方法對生成模型進行性能優(yōu)化,可以讓虛擬人物能夠以最佳方式感知環(huán)境、規(guī)避障礙并達到目的地。

主要通過獎勵函數(shù)的引導,使虛擬人物的運動變得更加自然和逼真。具體來說,當虛擬人物在生成過程中朝著期望的方向觀察時,將受到"注意"獎勵的正向反饋。

這意味著如果虛擬人物能夠集中注意力并關(guān)注與任務(wù)相關(guān)的對象或區(qū)域,將獲得額外的獎勵信號。這鼓勵虛擬人物在感知任務(wù)中更加專注和準確。

"注意"獎勵的實現(xiàn)方式可以根據(jù)具體情況進行調(diào)整。例如,在訓練過程中,可以通過監(jiān)測虛擬人物的視覺輸入和目標方向之間的一致性來計算獎勵值。

如果虛擬人物的注意力與任務(wù)目標的位置或運動方向相一致,獎勵值將增加;反之,如果虛擬人物的注意力偏離了任務(wù)目標,獎勵值將減少或為負值。

通過不斷優(yōu)化生成模型,并利用這些獎勵信號進行反饋,逐步改進了虛擬人物的行為,使其能夠準確地感知和適應(yīng)復雜的環(huán)境。

為了驗證EgoGen方法的有效性,研究人員在三個第一人稱的感知任務(wù)上進行了綜合評估:頭戴式攝像頭的建圖和定位、攝像頭跟蹤以及從第一視角恢復人體網(wǎng)格。

通過使用EgoGen生成的高質(zhì)量合成數(shù)據(jù),并提供精確的地面真實標注,現(xiàn)有的最先進算法在這些任務(wù)上的性能全部得到了大幅度增強。

本文素材來源EgoGen論文,如有侵權(quán)請聯(lián)系刪除

END

未經(jīng)允許不得轉(zhuǎn)載:RPA中國 | RPA全球生態(tài) | 數(shù)字化勞動力 | RPA新聞 | 推動中國RPA生態(tài)發(fā)展 | 流 > 創(chuàng)新性3D數(shù)據(jù)合成模型,微軟推出EgoGen

heng.png)

達觀助手智能寫作產(chǎn)品正式發(fā)布,全面提升寫作能力!

達觀助手智能寫作產(chǎn)品正式發(fā)布,全面提升寫作能力! 生成式AI為何不完全適用當下B2B行業(yè)?

生成式AI為何不完全適用當下B2B行業(yè)? Gartner:ChatGPT只是開始,企業(yè)生成式AI的未來

Gartner:ChatGPT只是開始,企業(yè)生成式AI的未來 ?中國何時能有ChatGPT?“現(xiàn)象級”產(chǎn)品背后的AI技術(shù)發(fā)展與展望

?中國何時能有ChatGPT?“現(xiàn)象級”產(chǎn)品背后的AI技術(shù)發(fā)展與展望

熱門信息

閱讀 (14728)

1 2023第三屆中國RPA+AI開發(fā)者大賽圓滿收官&獲獎名單公示閱讀 (13753)

2 《Market Insight:中國RPA市場發(fā)展洞察(2022)》報告正式發(fā)布 | RPA中國閱讀 (13055)

3 「RPA中國杯 · 第五屆RPA極客挑戰(zhàn)賽」成功舉辦及獲獎名單公示閱讀 (12964)

4 與科技共贏,與產(chǎn)業(yè)共進,第四屆ISIG中國產(chǎn)業(yè)智能大會成功召開閱讀 (11567)

5 《2022年中國流程挖掘行業(yè)研究報告》正式發(fā)布 | RPA中國