來自“歐洲OpenAI”的“最強(qiáng)7B開源模型”Mistral最近可謂是圈粉無數(shù)。

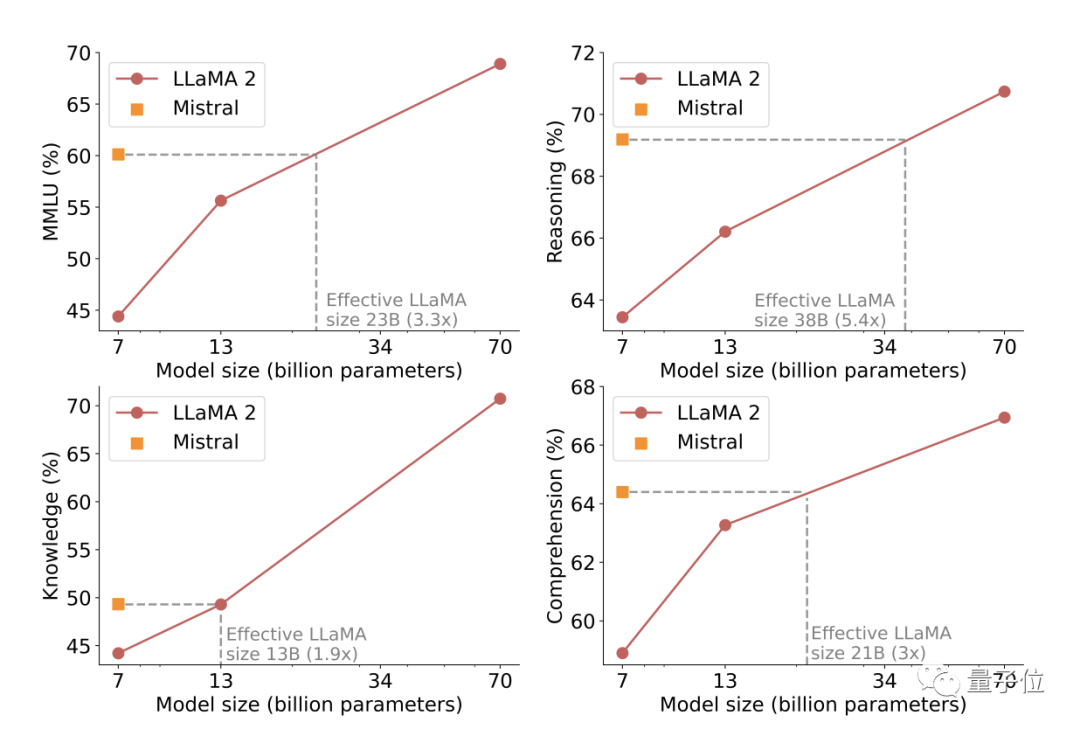

它各方面的測(cè)試指標(biāo)全面超越了13B的Llama2,甚至讓一眾網(wǎng)友覺得羊駝不香了。

最新消息是,Mistral AI團(tuán)隊(duì)已經(jīng)發(fā)布了相關(guān)論文,透露背后的技術(shù)細(xì)節(jié)。

Mistral不僅全面戰(zhàn)勝了13B Llama2,在數(shù)學(xué)、代碼和推理方面,34B的Llama1也不是Mistral的對(duì)手。

在推理任務(wù)上,Mistral的表現(xiàn)更是直逼10倍參數(shù)量的Llama2-70B。

但Mistral消耗的資源卻很少,只需要6GB顯存,MacBook就能流暢運(yùn)行。

為了用更少消耗達(dá)到更好的效果,Mistral可謂是使出了渾身解數(shù)。

那么關(guān)于Mistral的這篇論文都透露了哪些技術(shù)信息呢?

多種機(jī)制降低運(yùn)算消耗

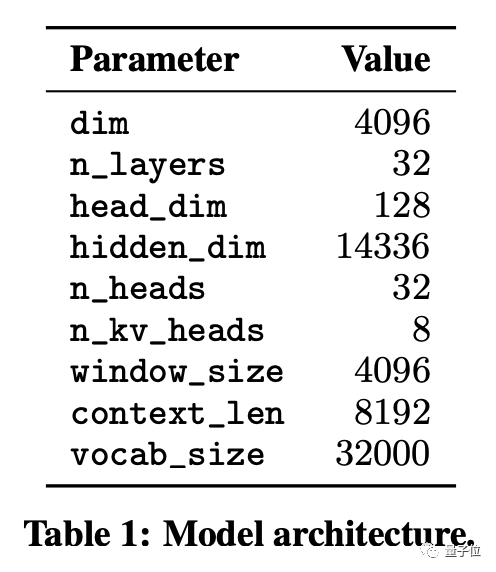

基礎(chǔ)結(jié)構(gòu)上,Mistral基于Transformer架構(gòu)設(shè)計(jì),一共有32個(gè)n_layer,上下文長(zhǎng)度達(dá)到了8192 token。

具體的參數(shù)如下表所示:

而Mistral能做到高性能低消耗,則要?dú)w功于所用到的多種優(yōu)化策略。

首先是最核心的注意力機(jī)制,其直接作用是減少計(jì)算量,具體包括了兩個(gè)方面。

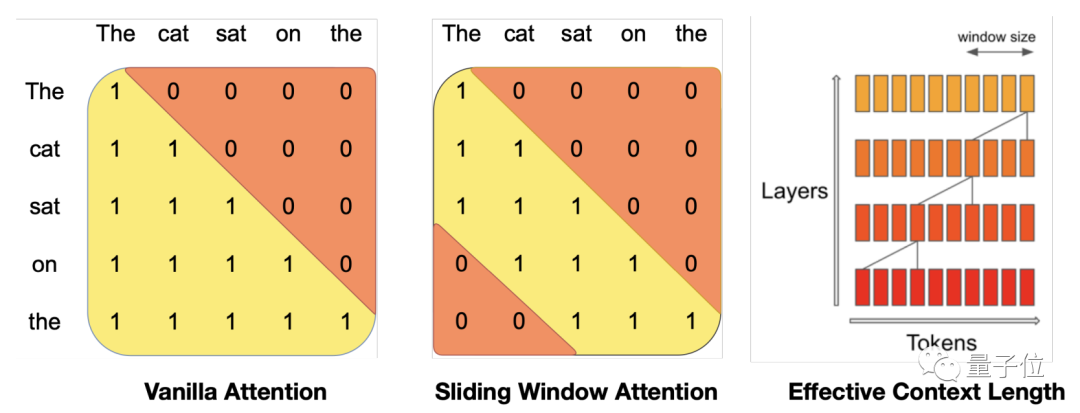

第一種是滑動(dòng)窗口(Sliding Window)注意力機(jī)制。

推理階段中,會(huì)設(shè)定出一個(gè)窗口長(zhǎng)度,并在劃分出的注意力層范圍之內(nèi)進(jìn)行注意力運(yùn)算,而不是針對(duì)全文。

通過滑動(dòng)方式,各注意力層之間會(huì)有所重疊,從而實(shí)現(xiàn)長(zhǎng)文本序列的處理。

4096的長(zhǎng)度,理論上可以處理13.1萬token。

這種注意力機(jī)制和標(biāo)準(zhǔn)注意力相比,可以將速度提升到兩倍。

另一種則是分組查詢(Grouped-query)注意力機(jī)制。

這種機(jī)制將查詢(query)拆分成多個(gè)組,每個(gè)組只與key的一個(gè)子集進(jìn)行注意力運(yùn)算,然后拼接出結(jié)果。

這樣不僅能降低運(yùn)算量,也能讓組間通信次數(shù)減少,并提高查詢吞吐。

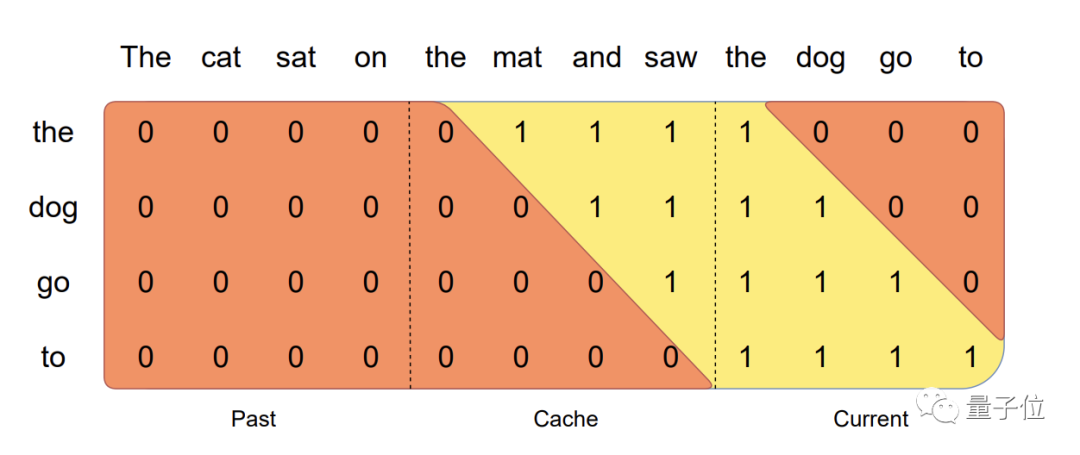

除了在注意力機(jī)制上下功夫,開發(fā)者還引入了滾動(dòng)緩沖區(qū)緩存(Rolling Buffer Cache)。

這種存儲(chǔ)方式固定了緩沖區(qū)的大小,從而限定了內(nèi)存消耗的最大值。

如果把緩沖區(qū)比作一座倉庫,每存進(jìn)一個(gè)新東西,都會(huì)占據(jù)相應(yīng)的位置。

而倉庫的總?cè)萘渴枪潭ǖ模?dāng)倉庫被裝滿時(shí),就會(huì)把最先放入的東西移除,讓新的物品繼續(xù)進(jìn)倉。

但入倉時(shí)間更接近的物品則會(huì)留在倉庫中,就能在節(jié)約資源的同時(shí)保留一定長(zhǎng)度的序列。

利用這種緩存機(jī)制,只要緩沖區(qū)大小設(shè)置得合理,就能實(shí)現(xiàn)預(yù)算效率與記憶力的平衡。

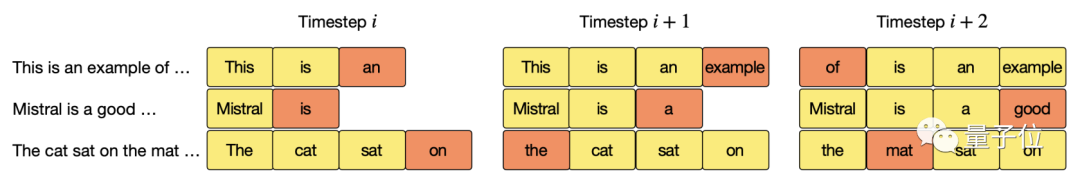

此外還有一種預(yù)填充和分塊機(jī)制,它的直接作用是減少重復(fù)運(yùn)算。

假如需要處理一個(gè)很長(zhǎng)的句子,那么這個(gè)句子將被分割成小塊。

訓(xùn)練完前面的小塊之后,再加入后面的塊,以此類推……

這樣存儲(chǔ)空間中就有了前面的塊信息,用來建立長(zhǎng)序列。

這種方式避免了從頭開始的重復(fù)運(yùn)算,從而使效率得到了提升。

以上就是開發(fā)者在Mistral中使用的優(yōu)化策略,而為了評(píng)估模型的泛化能力,開發(fā)者使用了HF上的公開數(shù)據(jù)集進(jìn)行了指導(dǎo)性微調(diào)。

結(jié)果Mistral的表現(xiàn)全面超過了13B參數(shù)的Llama 2,其中推理技能更是與70B版本十分接近。

單塊3090即可微調(diào)

Mistral的火爆程度,直接讓第三方工作室也推出了微調(diào)教程。

據(jù)介紹,用這種方法微調(diào)之后,可以進(jìn)一步提升Mistral的性能并降低消耗。

而這個(gè)微調(diào)的過程,用一塊3090就能完成。

首先是根據(jù)使用目的準(zhǔn)備數(shù)據(jù)集,轉(zhuǎn)化為prompt形式并劃分出訓(xùn)練和驗(yàn)證集。

然后是對(duì)模型進(jìn)行初始化,加載Mistral并設(shè)置4-bit量化和Lora等參數(shù)。

接著是構(gòu)建Trainer,輸入數(shù)據(jù)、模型等信息正式開始訓(xùn)練,然后測(cè)試并保存。

具體的細(xì)節(jié)可以到教程原文中去了解。

論文地址:

https://arxiv.org/abs/2310.06825

微調(diào)教程:

https://wandb.ai/byyoung3/ml-news/reports/Fine-Tuning-Mistral7B-on-Python-Code-With-A-Single-GPU---Vmlldzo1NTg0NzY5

本文來源量子位,如有侵權(quán)請(qǐng)聯(lián)系刪除

未經(jīng)允許不得轉(zhuǎn)載:RPA中國(guó) | RPA全球生態(tài) | 數(shù)字化勞動(dòng)力 | RPA新聞 | 推動(dòng)中國(guó)RPA生態(tài)發(fā)展 | 流 > “最強(qiáng)7B模型”論文發(fā)布,揭秘如何超越13B版Llama 2

heng.png)

達(dá)觀助手智能寫作產(chǎn)品正式發(fā)布,全面提升寫作能力!

達(dá)觀助手智能寫作產(chǎn)品正式發(fā)布,全面提升寫作能力! 生成式AI為何不完全適用當(dāng)下B2B行業(yè)?

生成式AI為何不完全適用當(dāng)下B2B行業(yè)? Gartner:ChatGPT只是開始,企業(yè)生成式AI的未來

Gartner:ChatGPT只是開始,企業(yè)生成式AI的未來 ?中國(guó)何時(shí)能有ChatGPT?“現(xiàn)象級(jí)”產(chǎn)品背后的AI技術(shù)發(fā)展與展望

?中國(guó)何時(shí)能有ChatGPT?“現(xiàn)象級(jí)”產(chǎn)品背后的AI技術(shù)發(fā)展與展望

熱門信息

閱讀 (14728)

1 2023第三屆中國(guó)RPA+AI開發(fā)者大賽圓滿收官&獲獎(jiǎng)名單公示閱讀 (13753)

2 《Market Insight:中國(guó)RPA市場(chǎng)發(fā)展洞察(2022)》報(bào)告正式發(fā)布 | RPA中國(guó)閱讀 (13055)

3 「RPA中國(guó)杯 · 第五屆RPA極客挑戰(zhàn)賽」成功舉辦及獲獎(jiǎng)名單公示閱讀 (12964)

4 與科技共贏,與產(chǎn)業(yè)共進(jìn),第四屆ISIG中國(guó)產(chǎn)業(yè)智能大會(huì)成功召開閱讀 (11567)

5 《2022年中國(guó)流程挖掘行業(yè)研究報(bào)告》正式發(fā)布 | RPA中國(guó)