騰訊開源了混元大模型的最新版本Hunyuan-A13B。

Hunyuan-A13B是一個專家混合模型,擁有800億參數,其中130億參數處于激活狀態。支持快、慢兩種思考模式:快速思維模式,提供簡潔高效的輸出,適用于高效、簡單的日常任務;慢速思維模式,支持更深層次的推理步驟包含反思和回溯,生成更長的思維鏈,提升復雜任務的準確性。

值得一提的是,Hunyuan-A13B特意針對AI Agent進行了強化,打造了應對不同場景變化的“自適應大腦”,設計超過30種智能體指令,并組合工具、動作、響應的格式變化,創造出20000種格式組合。

開源地址:https://huggingface.co/tencent/Hunyuan-A13B-Instruct

github:https://github.com/Tencent-Hunyuan/Hunyuan-A13B?tab=readme-ov-file

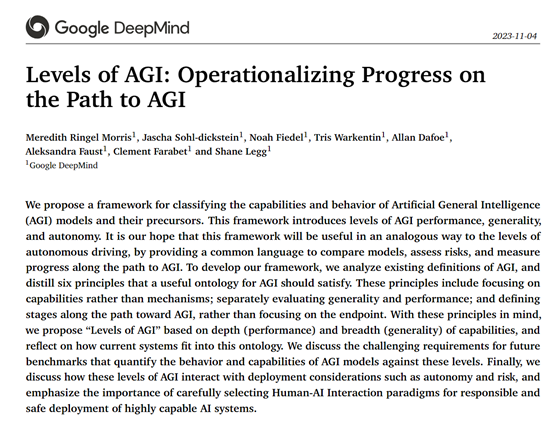

根據騰訊公布的測試數據顯示,在數學AIME2024、AIME2025測試中,Hunyuan-A13B分別拿下了87.3、76.8的高分,超過了DeepSeek-R1的79.8、70分,同時也大幅度超過了OpenAI的o1模型。

在科研、代碼、推理的測試中,Hunyuan-A13B與DeepSeek-R1的測試結果幾乎差不多。

而在Agent智能體BFCL-V3、ComplexBench、C-TurcBench測試中,Hunyuan-A13B分別拿下78.3、61.2、63.5的高分,全部大幅度超過了DeepSeek-R1的56.9、41.1、55.3。

在架構設計方面,Hunyuan-A13B由1個共享專家和64個細粒度非共享專家組成,所有專家的中間維度相同。在訓練階段,共享專家始終處于激活狀態,而非共享專家中只有8個會同時被激活。

為了進一步提升模型的性能,Hunyuan-A13B在激活函數上采用了SWiGLU,這與Hunyuan-Large和Hunyuan-TurboS保持一致。此外,模型在注意力層中引入了Grouped-Query Attention顯著提高了KV緩存的內存效率,使得Hunyuan-A13B在處理復雜任務時能夠更加高效地利用計算資源。

在推理過程中,Hunyuan-A13B還采用了雙模式推理鏈框架,這一框架允許模型根據任務的復雜性和用戶需求動態調整推理深度。

快速思考模式旨在為簡單任務提供快速、高效的解決方案。在這種模式下,模型會生成簡潔的輸出,以最小的計算開銷滿足用戶的需求。這種模式特別適合那些對速度要求較高的場景,例如,實時問答或簡單的信息檢索任務。通過快速思考模式,Hunyuan-A13B能夠在極短的時間內給出答案,來提高用戶體驗。

慢速思考模式,這種模式適用于更復雜的任務,如多步推理問題。在這種模式下,模型會進行更深入、更全面的推理過程,包括但不限于反思和回溯等步驟。這使得模型能夠生成更長的推理鏈,從而提高在處理復雜問題時的準確性和魯棒性。

在后訓練階段,Hunyuan-A13B采用了結構化的多階段方法,旨在全面提升模型在各個維度的性能。這一階段包括推理導向的監督微調(SFT)和強化學習(RL)階段,以及全場景監督微調和強化學習階段。

在推理導向的SFT階段,模型專注于加強在復雜推理導向任務方面的專業能力,例如,數學推理、邏輯推理、代碼生成和科學分析等。這一階段使用了精心策劃的指令-響應數據集進行監督微調,這些數據集包含了明確的推理過程和詳細的推理解決方案。

在強化學習階段,模型進一步增強了推理能力。這一階段利用了兩種類型的獎勵機制:結果獎勵模型和沙箱反饋。結果獎勵模型是一種輕量級的語言模型基礎驗證器,用于評估生成的最終答案與參考答案之間的一致性,并據此給出二元獎勵。

沙箱反饋則通過一個多語言代碼沙箱來提供實際的代碼執行結果,從而為模型提供更準確的反饋。這些獎勵機制的結合,使得模型能夠在推理過程中不斷優化和改進。

在全場景監督微調階段,模型的適應性得到了進一步的拓寬。這一階段涉及在多樣化指令-響應數據集上的監督微調,旨在提高模型在創意寫作、基于知識的問答、指令遵循以及多輪對話任務等多樣化實際場景中的表現。

與推理導向的微調階段不同,這一階段的強化學習采用了雙重信號優化方法,不僅評估最終輸出的正確性,還通過一個大型語言模型作為智能體評估器來評估風格質量、連貫性和適應性。這種全面的評估策略使得模型能夠在提高準確性的同時,增強在不同應用場景中的可用性。

為了進一步提升模型在特定領域的表現,在全場景強化學習階段Hunyuan-A13B還引入了多個專門的獎勵服務和數據構建流程。這些服務和流程針對不同的能力領域進行了優化,確保模型在各個領域都能達到高標準的表現。例如,在文本理解領域,模型不僅需要能夠準確回答問題,還需要在風格和連貫性上符合語言習慣。為此,研究人員設計了專門的一致性模型和比較性GRM,以確保模型輸出在客觀和主觀任務中都能保持高質量。

在智能體任務中,模型需要能夠有效地調用工具,并根據工具的反饋進行合理的決策。為此,研究人員構建了基于規則的獎勵機制,以確保模型在調用工具時能夠遵循正確的格式和邏輯。這種獎勵機制的引入,使得模型在智能體任務中能夠更加高效地完成任務,并且在多輪對話中保持良好的連貫性和一致性。

在復雜指令任務中,模型需要能夠精確地理解和執行多方面的指令。為此,研究人員將約束提取和滿足工具與通用批評和獎勵模型相結合,確保模型在執行復雜指令時能夠嚴格遵循指令要求,并且在多步推理過程中保持邏輯連貫性。

在安全領域,模型需要能夠識別和避免潛在的風險和不當內容。為此,研究人員使用分類器和拒絕啟發式方法來識別安全響應對,并將安全對齊直接整合到偏好數據集中。這種整合方法使得模型在生成內容時能夠更加注重安全性,從而降低風險。

本文素材來源騰訊,如有侵權請聯系刪除

未經允許不得轉載:RPA中國 | RPA全球生態 | 數字化勞動力 | RPA新聞 | 推動中國RPA生態發展 | 流 > 媲美DeepSeek!騰訊開源新版混元模型:AI Agent強化,超30種智能體指令

heng.png)

拯救者杯OPENAIGC開發者大賽今日迎來決賽,現場179支參賽團隊角逐AI桂冠

拯救者杯OPENAIGC開發者大賽今日迎來決賽,現場179支參賽團隊角逐AI桂冠 為何說數字化的本質就是自動化

為何說數字化的本質就是自動化 科技爆炸,白領辦公新style,工作吩咐一聲,電腦自動完成

科技爆炸,白領辦公新style,工作吩咐一聲,電腦自動完成 如何通過人工智能和自動化提高供應鏈彈性?

如何通過人工智能和自動化提高供應鏈彈性?

熱門信息

閱讀 (15812)

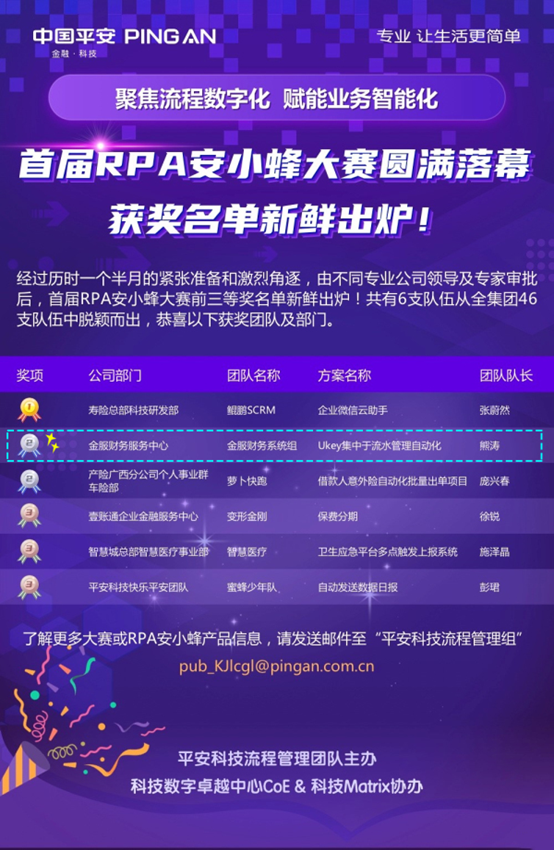

1 2023第三屆中國RPA+AI開發者大賽圓滿收官&獲獎名單公示閱讀 (15196)

2 《Market Insight:中國RPA市場發展洞察(2022)》報告正式發布 | RPA中國閱讀 (13358)

3 「RPA中國杯 · 第五屆RPA極客挑戰賽」成功舉辦及獲獎名單公示閱讀 (13197)

4 與科技共贏,與產業共進,第四屆ISIG中國產業智能大會成功召開閱讀 (12461)

5 財務機器人 —— RPA的財務應用