Gemma與谷歌最新發布的Gemini 使用了同一架構,有20億、70億兩種參數,每種參數都有預訓練和指令調優兩個版本。

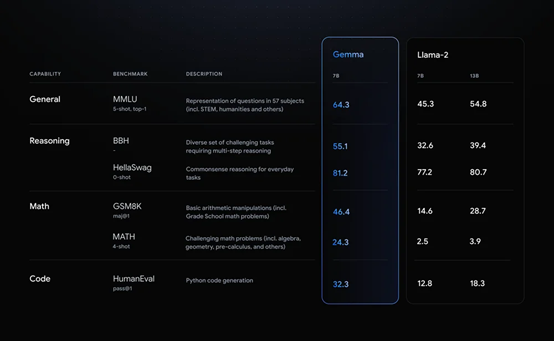

根據谷歌公布的測試顯示,在MMLU、BBH、GSM8K等主流測試平臺中,其70億模型在數學、推理、代碼的能力超過Llama-2的70億和130億,成為最強小參數的類ChatGPT模型。

目前,Gemma可以商用,并且普通筆記本、臺式機就能跑,無需耗費巨大的AI算力矩陣。

Kaggle地址:https://www.kaggle.com/models/google/gemma/code/

huggingface地址:https://huggingface.co/models?search=google/gemma

技術報告:https://goo.gle/GemmaReport

谷歌作為貢獻出Transformers、TensorFlow、BERT、T5、JAX、AlphaFold等一系列改變世界AI發展的宗師級大師,在生成式AI領域卻一直落后于OpenAI。

不僅如此,開源領域還打不過類ChatGPT開源鼻祖Meta的Llama系列。痛定思痛之后,谷歌決定重新加入開源陣營,以搶奪開發者和用戶。

Gemma簡單介紹

谷歌表示,Gemma之所以性能如此強悍,主要是使用了與Gemini相同的技術架構。

更詳細的開發者指南:https://ai.google.dev/gemma/docs?utm_source=agd&utm_medium=referral&utm_campaign=quickstart-docu

Gemini的基礎架構建立在Transformer編碼器結構之上,通過多層自注意力和前饋神經網絡來建模序列依賴性。不同的是Gemini采用了多查詢注意力機制,可處理超復雜長文本。

具體來說,模型首先將輸入序列的每個位置編碼成多組查詢向量。然后,將這些查詢向量并行地與鍵值對進行批量注意力運算,得到多個注意力結果。

除了開源模型權重,谷歌還推出Responsible Generative AI Toolkit等一系列工具,為使用Gemma提供更安全的AI應用程序提供指導。

目前,Gemma開放了兩個版本:預訓練,該版本未針對 Gemma 核心數據訓練集以外的任何特定任務或指令進行訓練;指令微調,通過人類語言互動進行訓練,可以響應對話輸入,類似ChatGPT聊天機器人。

跨框架、工具和硬件,對Gemma進行優化

開發者可以根據自己的數據微調 Gemma 模型,以適應特定的應用程序需求,例如,生成摘要/文本或檢索增強生成 (RAG)等。Gemma 支持以下多種工具和系統:

多框架工具:可跨多框架 Keras 3.0、本機 PyTorch、JAX 和 Hugging Face Transformers 進行推理和微調。

跨設備兼容性:Gemma可以跨多種設備類型運行,包括筆記本電腦、臺式機、物聯網、移動設備和云,從而實現廣泛的 AI 功能。

高級硬件平臺:谷歌與NVIDIA合作,針對 NVIDIA GPU 優化 Gemma模型,從數據中心到云端再到本地RTX AI PC,提供行業領先的性能并與尖端AI技術集成。

針對 Google Cloud 進行了優化:Vertex AI 提供廣泛的 MLOps 工具集,具有一系列調整選項,并可使用內置推理優化功能進行一鍵式部署。

高級定制功能可通過完全管理的頂點人工智能工具或自我管理的GKE 實現,包括部署到 GPU、TPU 和 CPU 平臺上具有成本效益的基礎設施。

Gemma性能測試

谷歌在MMLU、BBH、GSM8K等主流測試平臺中,用Gemma 70億模型與Llama-2、Mistral在數學、推理、代碼等方面進行了深度測試。

Gemma的標準學術基準測試平均分數都高于同規模的Llama 2和Mistral模型。甚至在一些關鍵能力方面,高于Llama-2 130億參數模型。

也就是說,Gemma是一款參數很小,性能卻異常強悍的大模型。

本文素材來源谷歌官網,如有侵權請聯系刪除

END

未經允許不得轉載:RPA中國 | RPA全球生態 | 數字化勞動力 | RPA新聞 | 推動中國RPA生態發展 | 流 > 谷歌掀桌子!開源Gemma:可商用,性能超過Llama 2!

heng.png)

達觀助手智能寫作產品正式發布,全面提升寫作能力!

達觀助手智能寫作產品正式發布,全面提升寫作能力! 生成式AI為何不完全適用當下B2B行業?

生成式AI為何不完全適用當下B2B行業? Gartner:ChatGPT只是開始,企業生成式AI的未來

Gartner:ChatGPT只是開始,企業生成式AI的未來 ?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

熱門信息

閱讀 (14728)

1 2023第三屆中國RPA+AI開發者大賽圓滿收官&獲獎名單公示閱讀 (13753)

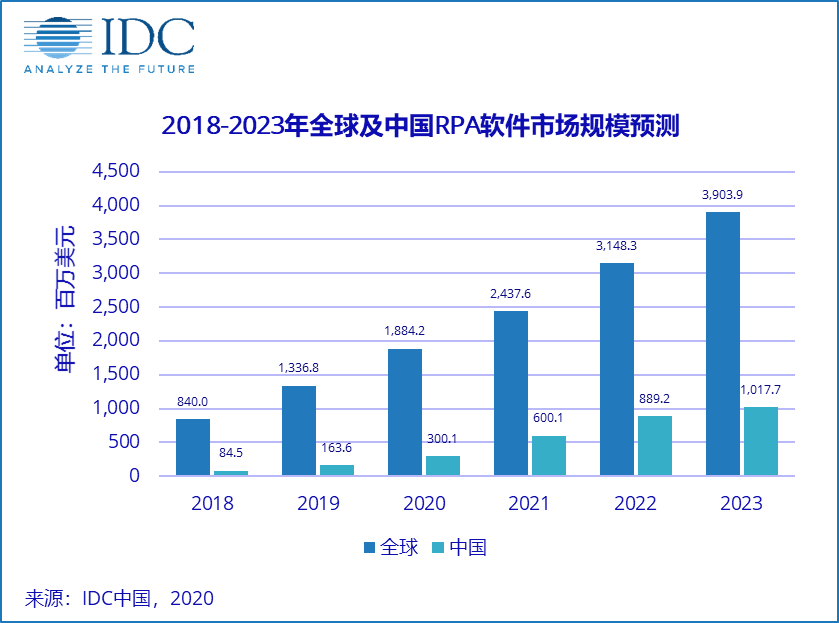

2 《Market Insight:中國RPA市場發展洞察(2022)》報告正式發布 | RPA中國閱讀 (13055)

3 「RPA中國杯 · 第五屆RPA極客挑戰賽」成功舉辦及獲獎名單公示閱讀 (12964)

4 與科技共贏,與產業共進,第四屆ISIG中國產業智能大會成功召開閱讀 (11567)

5 《2022年中國流程挖掘行業研究報告》正式發布 | RPA中國