隨著OpenAI發布GPT-4V后,多模態功能逐漸成為主流,并涌現出了MiniGPT-4、LLaVA等卓越多模態開源模型。

微軟研究院、威斯康星大學的研究人員在LLaVA基礎之上,繼續開源了LLaVA-1.5版本。與前一代相比,LLaVA-1.5引入了跨模態連接器和特定格式的學術視覺問答數據集,全面提升了多模態理解和生成能力。

為了評估LLaVA-1.5的性能,研究人員在MMEMM、BenchMM、SQA、POPE等11個知名數據平臺中對視覺問答、自然語言處理、圖像生成等進行了測試。結果顯示,LLaVA-1.5皆實現了開源模型中的最高水平,可媲美GPT-4V效果。

開源地址:https://github.com/haotian-liu/LLaVA

在線demo:https://llava.hliu.cc/

論文地址:https://arxiv.org/abs/2310.03744

LLaVA-1.5簡單介紹

LLaVA-1.5繼續使用了之前的LLaVA總體架構,由視覺模型、大語言模型和視覺語言連接器三大塊組成。還使用了一個MLP連接器取代原來的線性投影,大幅度提升了視覺理解和生成能力。

1)視覺模型:LLaVA-1.5使用了一個在大規模數據上預先訓練好的視覺模型CLIP ViT-L/336px來提取圖像的特征表示。

經過CLIP編碼后,可以得到一個固定長度的向量表示,來表征圖像的語義信息。與之前的LLaVA版本相比,CLIP模型的參數量和輸入分辨率皆有大幅提升。

2)大語言模型:使用了一個有130億參數的Vicuna v1.5的大語言模型,來幫助LLaVA-1.5理解用戶輸入的文本內容,同時可以捕獲文本的語義信息,具有強大的推理和生成能力。

與只進行圖像編碼器調優的方法不同,在LLaVA-1.5的訓練過程中,大語言模型的參數也會更新。這樣語言模型可以直接學會如何有效整合視覺信息進行推理,無需依賴其他模塊來控制其輸出,提高了模型的自主性。

3)視覺語言連接器:LLaVA-1.5使用了一個雙層的MLP連接器替代了之前的線性投影,可將CLIP編碼器輸出的圖像特征充分映射到大語言模型的詞向量空間中。

訓練方法、數據集和指令調優

在訓練流程方面,LLaVA-1.5遵循了LLaVA的雙階段訓練方式。第一階段,進行視覺語言表示的預訓練,使用約60萬張圖像文本對,大概訓練1個小時。第二階段,在65萬多模態指令數據上進行調優,大約使用了20小時。

這種高效雙階段訓練方法確保了模型的收斂性,也使得整個流程過程可以在一天內完成。相比那些需要訓練上百萬乃至上億樣本的模型來說,AI算力和時間成本都降了好幾個數量級。

訓練數據方面,LLaVA-1.5整合了6大類數據集,覆蓋視覺問答、語言對話等典型應用。包括:圖像問答數據集VQA,提供圖像-問題-答案三元組;OCR數據集,需要從圖像文字中抽取信息;

區域視覺問答數據集,需要關注和回答圖像局部內容;語言對話數據集,提供多輪聊天語料;等等。

此外,研究人員還特意設計了匹配的響應格式提示,指導模型根據交互類型調整輸出形式滿足特定場景需求。

視覺指令調優方面,LLaVA-1.5使用了不同類型的數據集,包括VQA、OCR、區域級VQA、視覺對話、語言對話等,一共約65萬條數據。這些數據為模型提供了豐富的視覺場景推理和交互方式。

本文素材來源LLaVA-1.5論文,如有侵權請聯系刪除

未經允許不得轉載:RPA中國 | RPA全球生態 | 數字化勞動力 | RPA新聞 | 推動中國RPA生態發展 | 流 > 可商用,超12000顆星!微軟開源多模態模型LLaVA-1.5

heng.png)

達觀助手智能寫作產品正式發布,全面提升寫作能力!

達觀助手智能寫作產品正式發布,全面提升寫作能力! 生成式AI為何不完全適用當下B2B行業?

生成式AI為何不完全適用當下B2B行業? Gartner:ChatGPT只是開始,企業生成式AI的未來

Gartner:ChatGPT只是開始,企業生成式AI的未來 ?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

熱門信息

閱讀 (14728)

1 2023第三屆中國RPA+AI開發者大賽圓滿收官&獲獎名單公示閱讀 (13753)

2 《Market Insight:中國RPA市場發展洞察(2022)》報告正式發布 | RPA中國閱讀 (13055)

3 「RPA中國杯 · 第五屆RPA極客挑戰賽」成功舉辦及獲獎名單公示閱讀 (12964)

4 與科技共贏,與產業共進,第四屆ISIG中國產業智能大會成功召開閱讀 (11567)

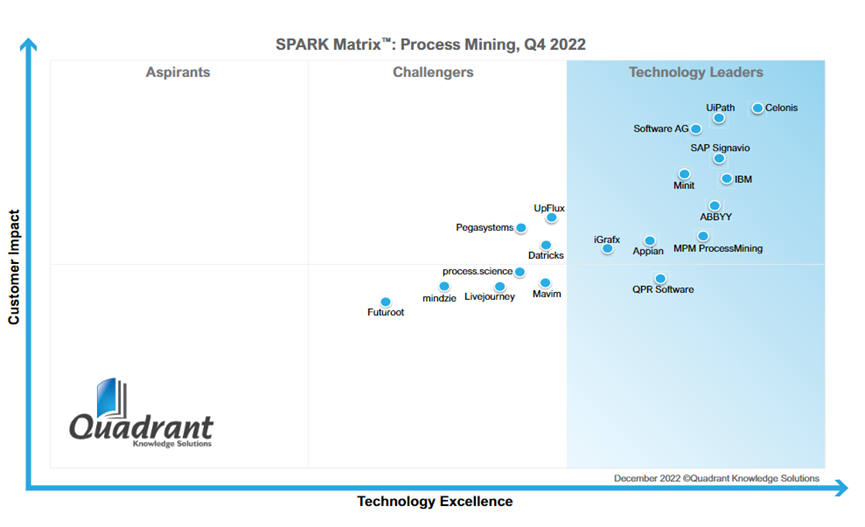

5 《2022年中國流程挖掘行業研究報告》正式發布 | RPA中國