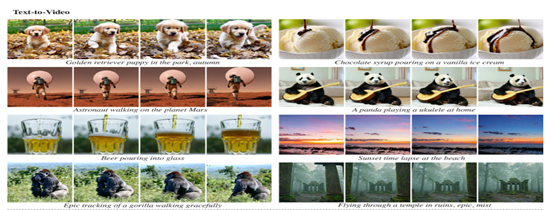

與傳統模型不同的是,Lumiere采用了一種時空擴散(Space-time)U-Net架構,可以在單次推理中生成整個視頻的所有時間段,能明顯增強生成視頻的動作連貫性,并大幅度提升時間的一致性。

此外,Lumiere為了解決空間超分辨率級聯模塊,在整個視頻的內存需求過大的難題,使用了Multidiffusion方法,同時可以對生成的視頻質量、連貫性進行優化。

論文地址:https://arxiv.org/abs/2401.12945?ref=maginative.com

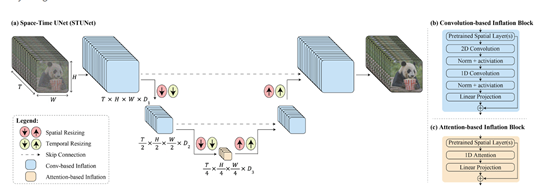

時空擴散U-Net架構

傳統的U-Net是一種常用于圖像分割任務的卷積神經網絡架構,其特點是具有對稱的編碼器-解碼器,能夠在多個層次上捕獲上下文信息,并且能夠精確地定位圖像中的對象。

而時空擴散U-Net是在時空維度上執行下采樣和上采樣操作,以便在緊湊的時空表示中生成視頻。

下采樣的目的是減小特征圖的尺寸,同時增加特征圖的通道數,以捕捉更豐富的特征。

上采樣則是通過插值以及將特征圖的尺寸恢復到原始輸入的大小,同時減少通道數,以生成更細節的輸出。

時空擴散U-Net的編碼器部分通過卷積和池化操作實現時空下采樣。卷積層用于提取特征,并逐漸減小特征圖的尺寸。

池化層則通過降采樣操作減小特征圖的空間尺寸,同時保留重要的特征信息。通過逐步堆疊這些下采樣模塊,編碼器可以逐漸提取出更高級別的抽象特征。

因此,Lumiere在時空擴散U-Net架構幫助下,能夠一次生成80幀、16幀/秒(相當于5秒鐘)的視頻。并且與傳統方法相比,這種架構顯著增強了生成視頻運動的整體連貫性。

Multidiffusion優化方法

Multidiffusion核心技術是通過在時間窗口內進行空間超分辨率計算,并將結果整合為整個視頻段的全局連貫解決方案。

具體來說,Multidiffusion通過將視頻序列分割成多個時間窗口,每個時間窗口內進行空間超分辨率計算。

這樣做的好處是,在每個時間窗口內進行計算可以減少內存需求,因為每個時間窗口的大小相對較小。同時,這種分割的方式也使得計算更加高效,并且能夠更好地處理長視頻序列。

在每個時間窗口內,Multidiffusion方法使用已經生成的低分辨率視頻作為輸入,通過空間超分辨率級聯模塊生成高分辨率的視頻幀。

然后,通過引入擴散算法,將每個時間窗口的結果進行整合,形成整個視頻段的全局連貫解決方案。

這種整合過程考慮了時間窗口之間的關聯性,保證了視頻生成的連貫性和視覺一致性。

本文素材來源Lumiere論文,如有侵權請聯系刪除

未經允許不得轉載:RPA中國 | RPA全球生態 | 數字化勞動力 | RPA新聞 | 推動中國RPA生態發展 | 流 > 文本生成高清、連貫視頻,谷歌推出時空擴散模型

heng.png)

達觀助手智能寫作產品正式發布,全面提升寫作能力!

達觀助手智能寫作產品正式發布,全面提升寫作能力! 生成式AI為何不完全適用當下B2B行業?

生成式AI為何不完全適用當下B2B行業? Gartner:ChatGPT只是開始,企業生成式AI的未來

Gartner:ChatGPT只是開始,企業生成式AI的未來 ?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

熱門信息

閱讀 (14728)

1 2023第三屆中國RPA+AI開發者大賽圓滿收官&獲獎名單公示閱讀 (13753)

2 《Market Insight:中國RPA市場發展洞察(2022)》報告正式發布 | RPA中國閱讀 (13055)

3 「RPA中國杯 · 第五屆RPA極客挑戰賽」成功舉辦及獲獎名單公示閱讀 (12964)

4 與科技共贏,與產業共進,第四屆ISIG中國產業智能大會成功召開閱讀 (11567)

5 《2022年中國流程挖掘行業研究報告》正式發布 | RPA中國