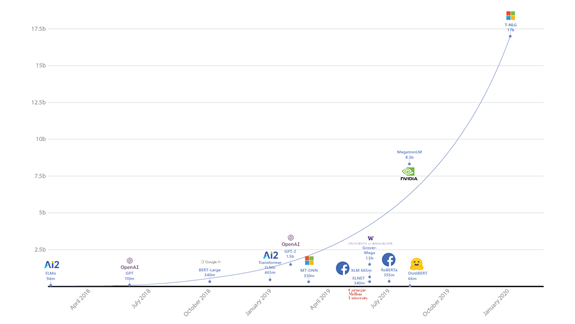

微軟AI&Research分享了有史以來,最大的基于Transformer架構(gòu)生成的模型Turing NLG并開源了一個(gè)名為Deep Speed深度學(xué)習(xí)庫,以簡(jiǎn)化對(duì)大型模型的分布式培訓(xùn)。基于Transformer架構(gòu),意味著該模型可以生成單詞來完成開放式文本任務(wù)。

2019年8月,英偉達(dá)曾發(fā)布世界上最大的基于Transformer的語言模型,當(dāng)時(shí)該模型使用了83億個(gè)參數(shù),比BERT大24倍,比Open AI的GPT-2大5倍。而此次微軟所發(fā)布T-NLG模型的參數(shù)為170億個(gè),是英偉達(dá)Megatron的兩倍,是Open AI GPT-2的十倍。

微軟表示,T-NLG在各種語言建模基準(zhǔn)上均優(yōu)于最新技術(shù),并在應(yīng)用于許多實(shí)際任務(wù)(文本總結(jié)和解析)上表現(xiàn)出色。

微軟AI科學(xué)家Corby Rosset在博客中寫道:“除了通過匯總文檔和電子郵件來節(jié)省用戶時(shí)間之外,T-NLG還可以通過為作者提供寫作幫助,并回答讀者可能對(duì)文檔提出的問題,由此來增強(qiáng)MicrosoftOffice套件的使用體驗(yàn)。”

微軟希望在任何情況下,AI都能夠像人類一樣直接,準(zhǔn)確,流暢地做出響應(yīng):以前,問題解析和內(nèi)容摘要依賴于從文檔中提取現(xiàn)有內(nèi)容,這些內(nèi)容可以作為備用答案或摘要,但它們通常看起來不自然或不連貫。使用T-NLG這樣的自然語言生成模型,可以自然地總結(jié)或回答有關(guān)個(gè)人文檔或電子郵件的問題。

此外,微軟還開源了一個(gè)名為Deep Speed的深度學(xué)習(xí)庫。該學(xué)習(xí)庫已針對(duì)開發(fā)人員進(jìn)行了優(yōu)化,以提供低延遲、高吞吐量的推理。Deep Speed包含零冗余優(yōu)化器(ZeRO),用于大規(guī)模訓(xùn)練具有1億個(gè)或更多參數(shù)的模型,微軟曾用它訓(xùn)練過T-NLG。

微軟表示,Deep Speed和ZeRO使得他們能夠降低模型并行度(從16降低到4),將每個(gè)節(jié)點(diǎn)的批處理大小增加四倍,并將訓(xùn)練時(shí)間減少了三分之二;DeepSpeed使用更少的GPU可以使大型模型的訓(xùn)練效率更高,開發(fā)人員和機(jī)器學(xué)習(xí)從業(yè)人員都可以使用DeepSpeed和ZeRO來訓(xùn)練自己的模型。

?

未經(jīng)允許不得轉(zhuǎn)載:RPA中國(guó) | RPA全球生態(tài) | 數(shù)字化勞動(dòng)力 | RPA新聞 | 推動(dòng)中國(guó)RPA生態(tài)發(fā)展 | 流 > 微軟發(fā)布史上最大AI模型:170億參數(shù),橫掃各種語言建模基準(zhǔn)

heng.png)

達(dá)觀助手智能寫作產(chǎn)品正式發(fā)布,全面提升寫作能力!

達(dá)觀助手智能寫作產(chǎn)品正式發(fā)布,全面提升寫作能力! 生成式AI為何不完全適用當(dāng)下B2B行業(yè)?

生成式AI為何不完全適用當(dāng)下B2B行業(yè)? Gartner:ChatGPT只是開始,企業(yè)生成式AI的未來

Gartner:ChatGPT只是開始,企業(yè)生成式AI的未來 ?中國(guó)何時(shí)能有ChatGPT?“現(xiàn)象級(jí)”產(chǎn)品背后的AI技術(shù)發(fā)展與展望

?中國(guó)何時(shí)能有ChatGPT?“現(xiàn)象級(jí)”產(chǎn)品背后的AI技術(shù)發(fā)展與展望

熱門信息

閱讀 (14728)

1 2023第三屆中國(guó)RPA+AI開發(fā)者大賽圓滿收官&獲獎(jiǎng)名單公示閱讀 (13753)

2 《Market Insight:中國(guó)RPA市場(chǎng)發(fā)展洞察(2022)》報(bào)告正式發(fā)布 | RPA中國(guó)閱讀 (13055)

3 「RPA中國(guó)杯 · 第五屆RPA極客挑戰(zhàn)賽」成功舉辦及獲獎(jiǎng)名單公示閱讀 (12964)

4 與科技共贏,與產(chǎn)業(yè)共進(jìn),第四屆ISIG中國(guó)產(chǎn)業(yè)智能大會(huì)成功召開閱讀 (11567)

5 《2022年中國(guó)流程挖掘行業(yè)研究報(bào)告》正式發(fā)布 | RPA中國(guó)