多模態生成一直是OpenAI、微軟、百度等科技巨頭的重要研究領域,但如何實現連貫的文本和相關圖像是一個棘手的難題。

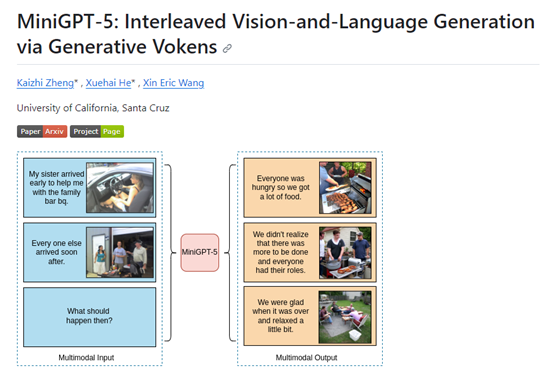

為了突破技術瓶頸,加州大學圣克魯斯分校研發了MiniGPT-5模型,并提出了全新技術概念“Generative Vokens ",成為文本特征空間和圖像特征空間之間的“橋梁”,實現了普通訓練數據的有效對齊,同時生成高質量的文本和圖像。

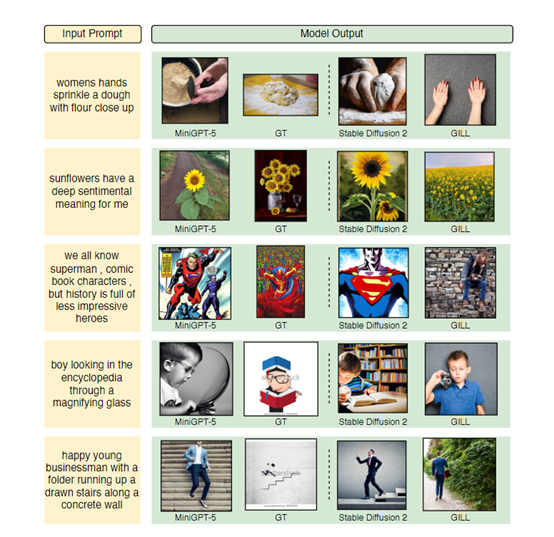

為了評估MiniGPT-5的效果,研究人員在多個數據集上進行了測試,包括CC3M、VIST和MMDialog。結果顯示,MiniGPT-5在多個指標上都優于多個對比基線,能夠生成連貫、高質量的文本和圖像。

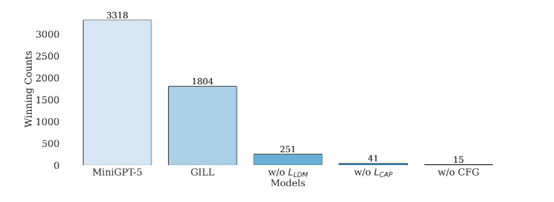

例如,在VIST數據集上,MiniGPT-5生成的圖像CLIP分數高于fine-tunedStable Diffusion 2; 在人類評估中,MiniGPT-5生成的語言連貫性更好(57.18%),圖像質量更高(52.06%),多模態連貫性更強(57.62%)。

在MMDialog數據集上,MiniGPT-5的MM相關性指標達到0.67,超過基準模型Divter的0.62。這充分證明MiniGPT-5在不同數據模式下的強大適應能力。

開源地址:https://github.com/eric-ai-lab/MiniGPT-5

論文地址:https://arxiv.org/abs/2310.02239

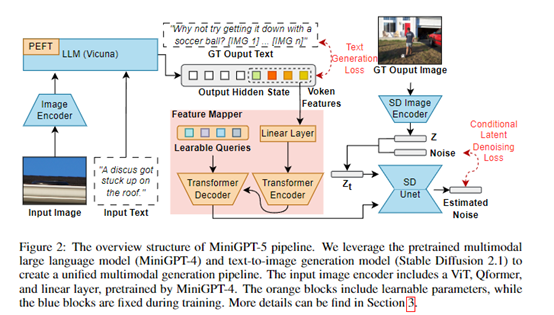

MiniGPT-5模型主要有3大創新點:1)利用多模態編碼器提取文本和圖像特征,代表了一種全新的文本與圖像對齊技術,效果優于直接利用大語言模型生成視覺token的方法。

2)提出了無需完整圖像描述的雙階段訓練策略:第一階段,專注文本與圖像的簡單對齊;第二階段,進行多模態細粒度特征學習。

3)在訓練中引入了“無分類器指導”技術,可有效提升多模態生成的內容質量。主要模塊架構如下。

Generative Vokens

MiniGPT-5的核心創新就是提出了“Generative Vokens”技術概念,實現了大語言模型與圖像生成模型的無縫對接。

具體來說,研究人員向模型的詞表中加入了8個特殊的Voken詞元[IMG1]-[IMG8]。這些Voken在模型訓練時作為圖像的占位符使用。

在輸入端,圖像特征會與Voken的詞向量拼接,組成序列輸入。在輸出端,模型會預測這些Voken的位置,對應的隱狀態h_voken用于表示圖像內容。

然后,h_voken通過一個特征映射模塊,轉換為與Stable Diffusion文本編碼器輸出對齊的圖像條件特征ˆh_voken。

在Stable Diffusion中,ˆh_voken作為指導圖像生成的條件輸入。整個pipeline實現了從圖像到語言模型再到圖像生成的對接。

這種通過Voken實現對齊的方式,比逆向計算要直接,也比利用圖像描述更為通用。簡單來說,Generative Vokens就像是一座“橋梁”,使不同模型域之間信息傳遞更順暢。

雙階段訓練策略

考慮到文本和圖像特征空間存在一定的域差異,MiniGPT-5采用了兩階段的訓練策略。

第一階段是單模態對齊階段:只使用單個圖像-文本對的數據,如CC3M。模型學習從圖像標題生成對應的Voken。同時,加入輔助的圖像標題損失,幫助Voken與圖像內容對齊。

第二階段是多模態學習階段:使用包含連續多模態樣本的數據,如VIST,進行微調。設置不同的訓練任務,包括生成文本、生成圖像和同時生成兩者。增強了模型處理多模態信息的能力。

這種分階段策略,可以緩解直接在有限數據上訓練帶來的問題。先進行粗粒度對齊,再微調細粒度特征,并提升了模型的表達能力和魯棒性。

無分類器指導

為進一步提升生成文本和圖像的連貫性,MiniGPT-5還采用了“無分類器指導”的技術。

其核心思想是,在圖像擴散過程中,以一定概率用零特征替換條件Voken,實現無條件生成。

在推理時,將有條件和無條件的結果作為正負樣本,模型可以更好地利用兩者的對比關系,產生連貫的多模態輸出。這種方法簡單高效,不需要引入額外的分類器,通過數據對比自然指導模型學習。

文本到圖像生成模型

MiniGPT-5使用了Stable Diffusion 2.1和多模態模型MiniGPT-4作為文本到圖像生成模型。可以根據文本描述生成高質量、高分辨率的圖片。

Stable Diffusion使用Diffusion模型和U-Net作為主要組件。Diffusion模型可以將圖片表示成噪聲數據,然后逐步進行去噪和重構。

U-Net則利用文本特征作為條件,指導去噪過程生成對應的圖片。相比GAN,Diffusion模型更穩定,生成效果也更清晰逼真。

為了準確地將生成標記與生成模型對齊,研究人員制定了一個用于維度匹配的緊湊映射模塊,并結合了一些監督損失,包括文本空間損失和潛在擴散模型損失。

文本空間損失幫助模型學習標記的正確位置,而潛在擴散損失直接將標記與適當的視覺特征對齊。由于生成Vokens的特征直接由圖像引導,因此,不需要圖像的全面描述就能實現無描述學習。

研究人員表示,MiniGPT-5的最大貢獻在于實現了文本生成和圖像生成的有效集成。只需要普通的文本、圖像進行預訓練,就可以進行連貫的多模態生成,而無需復雜的圖像描述。這為多模態任務提供了統一的高效解決方案。

本文素材來源加州大學圣克魯斯分校論文,如有侵權請聯系刪除

未經允許不得轉載:RPA中國 | RPA全球生態 | 數字化勞動力 | RPA新聞 | 推動中國RPA生態發展 | 流 > 突破性技術!開源多模態模型—MiniGPT-5

heng.png)

達觀助手智能寫作產品正式發布,全面提升寫作能力!

達觀助手智能寫作產品正式發布,全面提升寫作能力! 生成式AI為何不完全適用當下B2B行業?

生成式AI為何不完全適用當下B2B行業? Gartner:ChatGPT只是開始,企業生成式AI的未來

Gartner:ChatGPT只是開始,企業生成式AI的未來 ?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

?中國何時能有ChatGPT?“現象級”產品背后的AI技術發展與展望

熱門信息

閱讀 (14728)

1 2023第三屆中國RPA+AI開發者大賽圓滿收官&獲獎名單公示閱讀 (13753)

2 《Market Insight:中國RPA市場發展洞察(2022)》報告正式發布 | RPA中國閱讀 (13055)

3 「RPA中國杯 · 第五屆RPA極客挑戰賽」成功舉辦及獲獎名單公示閱讀 (12964)

4 與科技共贏,與產業共進,第四屆ISIG中國產業智能大會成功召開閱讀 (11567)

5 《2022年中國流程挖掘行業研究報告》正式發布 | RPA中國